AI主播特点?

1.码合成的主播技术是通过三维信息科技手段将人的外在形象信息赋予。“机器人”的方式直接呈现给受众的,科学信息技术不断的进步,促使人工智能核心技术也在不断完善,日趋成熟的人工智能技术使初具雏形的传统虚拟主播,逐步完成了向人工智能化合成主播转型的升级。

基于人工智能技术的智能主播发展越来越快,其被应用的区域也在不断扩大,当下的“AI合成主播”己经被广泛投入于中国传播领域的多个行业当中。在主持传播领域中,不同的人在不同的工作岗位扮演着不同的角色且有着不同的工作侧重点,由此一来,针对“AI合成主播”本身的特点,也应有其特定的明确分工。

一、“AI合成主播”的劣势

人工智能技术发展至今,虽己在很多方面实现了突破,但在某些方面仍存在不足,例如灵活性、技术性、细节性等。智能技术发展过快使其在社会上引起了争议。“人工智能批判说”等观点的提出,也使人们需要重新审视这项技术的发展,就“AI智能主播”来讲,目前有几大发展困境。

首先“AI合成主播”没有“自我意识”,即并不具备与人类感同身受的能力,这就导致其在情感方面有所欠缺,甚至可能会出现情感逻辑漏洞。由于“AI合成主播”逻辑来源于“程序”,而程序又是预先设定的,所以在词汇的掌握和运用上无法完全达到“得心应手”的程度。

在信息的“传递”上,有声语言内部技巧(情景再现、对象感、内在语)的缺失,以及外部技巧(停连、重音、语气、节奏)的不足,将“AI合成主播”的问题暴露在其语流音变的处理上,从而体现在给受众带来的视听效果中。尽管通过不断的升级,现下的“AI合成主播”越来越“逼真”。

但以“咬文嚼字”来形容仅限于进行固定文本播报,以及初级交流的“AI合成主播”想必再合适不过了。以网络上粉丝最多的虚拟主播“小冰”为例,“小冰”刚刚与大家见面的时候,还只是电视虚拟主播,是一档微博粉丝破百万的气象类节目主持人。

她凭借自身拥有的高容量的词库和现代语句组织技术,以及在线编辑文字和分析数据的能力,能够相对妥善地完成与粉丝之间的互动。且能够对粉丝在微博上的评论进行回答,实现相对较好的人机互动,形成一种新型网络交流模式。

但我们仍不能忽视此中的“反伊莉莎效应”,即人类思想的自由性,导致其不由自主地通过潜意识的认知,将“AI合成主播”的能力夸大化,从而导致对机器的反馈进行过度解读。细细观察我们其实可以发现,因为程序的预先设定致使“AI合成主播”,只有几种预设的反应结果。

即在无法捕捉社交线索的基础上,他(她)们只能完成同受众的“弱交流”,多次尝试后便不能令使用者延续其探索和关注的欲望,所以当有其他吸引受众眼球的新技术出现,“AI合成主播”将会失去原有关注度和市场。其次,当下的“AI合成主播”仍主要以辅助的形式存在。

虽相较于起步阶段而言,“AI合成主播”在技术层面己经有了很大的提升,但仍不足以支撑其独立完成主持或播音工作。于媒体中亮相的他(她)们能够吸引受众关注很大一部分原因来自于受众的新鲜感,能否被受众完全接受,从而真正完全投入使用仍需接受时间的考验。

依附于播音员和主持人品牌形象出现的“AI合成主播”,都是通过合成技术生成的,且不说其本身就是依托原型而存在的,仅在形式上就存在着趋向单一、创新度不足等问题。由于“AI合成主播”的受众大多来源于其原型,因此其发展也在某种程度上亦局限于原型,但若进行突破性创新,反而会使原有受众感觉到其与原型相似度降低。

从而降低受众关注度。这恰恰在某种程度上印证了“信息茧房”理论,即人们的信息领域会习惯性地被自身兴趣引导和局限,而对信息传播者的偏好亦能影响其感兴趣程度。于“AI合成主播”而言,虽然技术的发展能够为受众提供更多选择的可能性,但受众仍会因为潜在的习惯和固化印象,难以接受作为原型分身的“AI合成主播”,在某些方面的突破性变革。

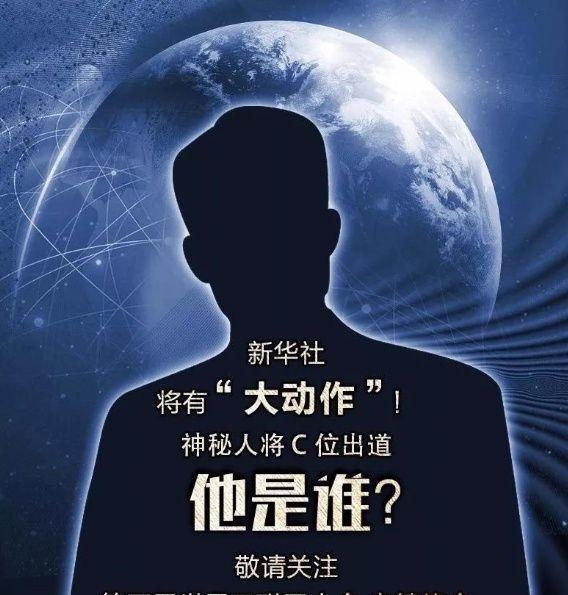

最后从播音与主持专业的角度来看,“AI合成主播”的专业性仍有所欠缺。以2020年2月16日于广西卫视新媒体平台上线的广西广播电视台首位“AI合成主播小晴”为例,在利用受众碎片化时间传递信息的“小屏传播”方式逐渐兴起的当下,“小晴”运营团队通过在线刷新信息,并于控制系统中输入文稿后,人工智能系统快速自动生成播报的优势立足于传媒行业。

但我们在惊叹,其通过包括面部表情、语音面貌在内的大量数据采集,加之“唇动”等技术的提升,使“AI合成主播”形象还原度和逼真度日趋提升的同时,亦不能忽视“眼神”和“语气”作为传递感情和交流细节的重要性。传播者作为信息传播的“意见性引领者”,其播报新闻的态度影响着新闻传播的效果。

通过大数据的分析,我们可以发现“AI合成主播”小晴的语流已相对流畅,但眼神仍缺少交流感,对各类新闻的播报基调依旧单一,这就会导致受众长时间获取信息时易产生“疲劳感”。除此以外,缺乏灵活性的语流音变、表意不明的机械化停顿、缺乏寓意的见字出声都影响着特定语境下文字有声化传播的效果。

由此看来,相较于传统播音员和主持人而言,“AI合成主播”仍存在较大的提升空间。如今的“AI合成主播”,仍不具备对信息进行“深化分析”的能力,更不能达到直接“创造内容”的程度,虽然目前己经有一部分“AI合成主播”,可以根据现有的相关资料,创造有价值的内容。

但是这些创造仍然是建立在,人类赋予他(她)们的“参考资料”也就是数据库上完成的,于“AI合成主播”而言,距离能够进行自主创造还有很长的一段路要走。

因此找准定位,深入研发和探索。继续加强人工智能技术与媒体融合,将有助于推动全媒体在媒体手段等各个方面的创新,也将有助于媒体更高效地,实现对文稿内容及播报内容的无差错管理。

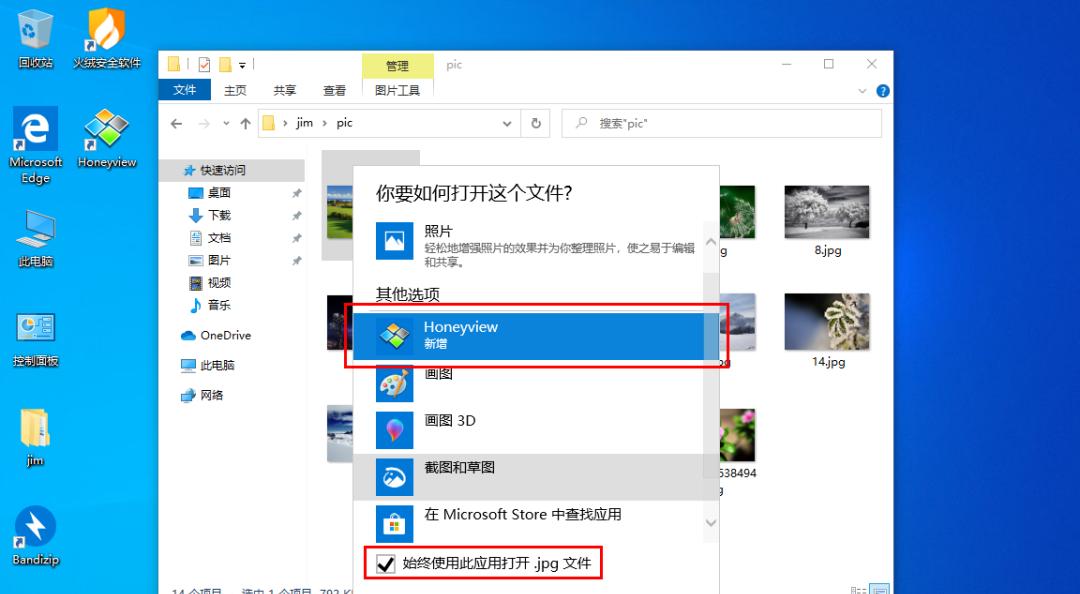

世界第一个“AI合成主播”在新华社上岗,你怎么看?

11月7日,第五届世界互联网大会在浙江乌镇拉开帷幕。新华社一张前所未有的海报吸引了很多人的注意。

这次新华社的神秘人物,既不是什么国际政要,也不是什么企业名流,而TA——新华社和搜狗联合开发的“AI合成主播”。第二天也即11月8日便是中国记者节,不知道过节的记者们看到来“抢饭碗”的AI主播,心里会作何感想?

新华社:全球首个AI主播

“大家好,我是今天的新闻主播……”在博览会1号展馆的搜狗公司展位,与真人主播真假难辨的“AI虚拟主播”,正进行着当日新闻播报。

这是如何做到的?现场工作人员介绍,由一位真人主播面对镜头录制播报1个小时的新闻,再通过“搜狗分身”技术,对真人主播的视频和语音数据进行特征提取,再通过语音合成、唇形合成以及深度学习等技术,“AI虚拟主播”便具备了和真人主播一样的播报能力。在此基础上,只需要提供文字,“AI虚拟主播”就能准确无误地像真人主播一样播出新闻。

在建社87周年之际,新华社联合搜狗发布的全球首个合成新闻主播——“AI合成主播”,运用最新人工智能技术,“克隆”出与真人主播拥有同样播报能力的“分身”。这不仅在全球AI合成领域实现了技术创新和突破,更是在新闻领域开创了实时音视频与AI真人形象合成的先河。

此次“AI合成主播”亮相,可以让网民感受到新华社“新员工”的业务能力,不仅中文“AI合成主播”实力“上岗”,同时还有以“联接中外、沟通世界”为使命的英文“AI合成主播”。

从主播“真人”到“分身”,“AI合成主播”可谓是经历了“九九八十一关”,有了多项人工智能前沿技术的“加持”,才走到了今天。从发布的这一刻起,“AI合成主播”正式成为新华社报道队伍中一员,TA将同其他主播一起,为我们带来权威、及时、准确的中英文新闻资讯。

与“真人”主播不同的是,“AI合成主播”竟然开了“外挂”!“真人”主播一天工作8小时,但“分身”能够不知疲倦地工作24小时!只要小编们将文本输入系统,TA们就能随时工作,并且一直工作下去……

无论是在日常报道中提升电视新闻的制作效率,降低制作成本,还是在突发报道中快速生成新闻视频,提高报道时效和质量,“AI合成主播”在不同的新闻场景运用中都拥有着不可限量的未来。

据介绍,“搜狗分身”技术可以让机器以更逼真自然的形象呈现在用户面前,而不是冷冰冰的“机器人”。该技术能通过人脸关键点检测、人脸特征提取、人脸重构、唇语识别、情感迁移等多项前沿技术,并结合语音、图像等多模态信息进行联合建模训练后,生成与真人无异的AI分身模型。“搜狗分身”技术是搜狗人工智能的核心技术之一,诞生于搜狗“自然交互+知识计算”这一人工智能理念之下。

搜狗公司CEO王小川表示,AI合成主播的诞生,将为媒体生产端带来无限想象空间,是智能时代大幅提升新闻生产、传播效率、新闻价值的有效手段。

据搜狗方面介绍,未来“搜狗分身”技术将在娱乐、医疗、健康、教育、法律等多个领域提供个性化的内容,显著提高社会生产和服务效率。

日本:Kizuna AI到Yomiko

虽然标榜全球首个合成新闻主播,但我们也要看到,去年十一月日本一个被玩家爱称为“人工智障爱酱”的虚拟主播便在Youtube上开始流传开来。这个名叫“Kizuna AI”的3D萌妹是个神经粗线条,偶尔又有些腹黑的人物。在视频镜头里,她时而恶意卖萌地说一些不着边际的话,时而颜艺丰富地自我吐槽,一下子就吸引了众多宅男的目光。

在这之后,日本放送协会(NHK)宣布将从今年4月开始在节目中使用人工智能(AI)主播Yomiko。通过CG技术制作的“主播”将在工作日晚间11时10分播出的“NEWS CHECK 11”节目中登场,每周播报一次约5分钟的新闻。“新闻主播Yomiko”将模拟真人主播的声音播报记者写成的新闻稿件。

技术人员事先请NHK旗下的主播阅读大量新闻稿件并录音,然后将这些语音数据分解为10万个音素。此外,还让Yomiko事先记住日本全国的地名、专有名词、口音等。

回到Kizuna AI身上,我们把片假名翻译成汉字,Kizuna的名字叫做“绊爱”,叫她作小爱似乎是为了暗合AI这个新的技术潮流。小爱在影片中对自己“人工智能”的身份有十足的认知。而她背后的运营团队甚至还组织过一次人工智能之间的对话,让小爱和苹果旗下的Siri对话。结果似乎是小爱完胜,把只会死板应答的Siri打得体无完肤。(和SIRI的会话,大家可以去youtube或B站观看)

技术:在变革中演进

小爱超人一等的表现让粉丝们不禁猜测,这个虚拟人物背后的支持引擎究竟是怎样强势的人工智能?有人甚至猜测,她背后的支持软件是日本文部科学省秘密研制的强人工智能,用虚拟偶像的面目出现在大众面前只是为了伪装和调试她的性能。这个推测显然是受到了去年10月份日本人工智能演员Rinna的启发。日本微软出品的这一款女演员机器人就是为了提高人工智能在各种情况下的表现能力。毕竟体验各种人生的最佳职业,莫过于演员了。

但熟悉现在人工智能技术发展潮流的人都会意识到,说小爱这个虚拟偶像是强人工智能显然还并不合适。以现在的技术进展来看,要像她这样能够对游戏画面也做出实时的正确反馈几乎是不可能的。用人工合成的说话声音,也没有办法达到像她一般流畅自然的水平。你只消看看别家合成出来的唱歌声音是多不自然就会对这个判断持支持的态度。

与其说是人工智能做出的实时反馈,倒不如说小爱其实背后有一个真实的演员在借助她的面具做表演。没错,把一个真人通过动态捕捉技术、人脸识别和人物建模技术结合起来,变成一个可爱的虚拟人物,在今天的技术条件下并不是什么天方夜谭。

首先是动作捕捉技术。这种技术最早被用于上个世纪的物理研究,专门用来分析物体的移动特性。后来,检测人体关节移动的设备被应用到了体育训练当中。随着体育界大量应用动作捕捉技术,影视动画和游戏行业也加入了这个行列。在探访大片制作现场的时候,如果你看到有人穿着一件镶嵌着无数白点的黑衣服在做奇怪的动作,就一定是在给动态捕捉拍摄底板。通过把人体关节动作在计算机中重新解析和配上肌肉,动画人物就能做出和演员一模一样的动作了。今年Adobe大会上动作抠图的展示也正是这个原理。

尽管动态捕捉技术相当省事,但它也有自己的破绽。最经常会出现的两个问题是翻关节和穿模。所谓翻关节就是在人物的运动中,关节处出现了有悖常理的翻着,比如俗语所说的“胳膊肘往外拐”。出现这种问题很有可能是计算机在识别关节位点时出现了误读,把不是关节的点认作关节了。而穿模问题的发生则和演员与动画人物的身材拉伸失调有关系。如果让一个瘦演员演胖人物,那动画胖子的手就会常年穿透自己的肚子出现在奇怪的地方。

小爱身上就经常发生这两个问题,关节反转不说,有时候还会在手放在胸口时穿透胸部,伸到里面去。其实这两个问题都是可以通过人工调试消除的,否则动态捕捉的真实性就没有价值了。可惜小爱在Youtube上的视频需要做到每日一更,主创人员对有的失误就只能听之任之了。

面部捕捉技术其实也并不令我们陌生。无论是习惯看国外直播平台还是国内直播平台的观众,都会在2015年开始发现有些房间的主播界面是一只可爱的动物。或猫或狗或浣熊的动物脑袋伴随着主播节奏在摇头晃脑、做出奇特的表情。完成这一创举的是一款叫做Facerig的应用,经常看游戏直播的读者想必都听说过这个名号。

应用于电影制作的人脸识别技术并不是什么新鲜事物,早在《阿凡达》和《猩球崛起》的时代,好莱坞就已经拥有成熟的人脸识别套路了。人脸识别其实和动作捕捉在原理上没有太多的区别,只是人脸肌肉的移动精密度更高,更难以捕捉细节而已。

十年前的人脸识别仍然需要在演员脸上贴上反光纸或者点上荧光染料,无论如何总还是会有点影响表演。而且当时的人脸识别需要很复杂的标定流程,只要一台摄像机的位置稍有变化,整个现场就需要全部重新标定。

随着对人脸识别的算法进步,这个问题至少在短距离上已经解决了。软件通过摄像头捕捉到的面部表情被简化成80多个位点,在卡通人物的脸上移动相应的位点就能模拟出人做的表情。当然这样的模拟不可能做到十全十美,有时候多少还是会有点变形。但只要神似,人们在快乐之间也就不会去深究什么了。虚拟偶像小爱在打游戏受到惊吓、感到惊喜时的丰富表情经常有一定的时滞,几乎已经可以确定是类似技术的产物了。

人物建模就更不是什么难题,事实上这往往是现实人物构建虚拟人物的第一步。小爱让人觉得可爱本就是题中应有之义。有了这样的人物形象,即使小爱并非真正的人工智能而只是一个把配音演员二次元化的动画人物,又有什么关系呢?

所以我们看到现在的新华社虚拟主播,其所应用的技术在很早之前就已经开始研究,只是在目前的情况下借助技术和算法的突破,采用真实人脸模式,让虚拟人物更加鲜活有生命,而不再只是一个语言和表情都很僵硬的机器存在。随着人工智能数据的积累、技术的发展,真的能让支持节目的主播真假难辨也说不定。

未来已来,我们一起期待。